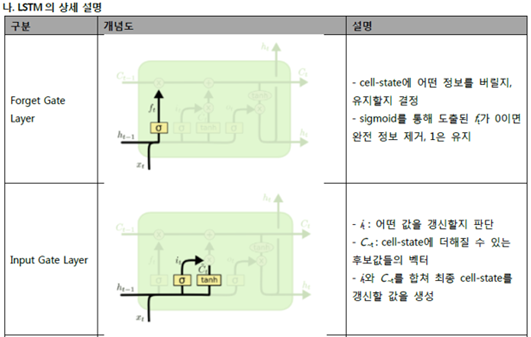

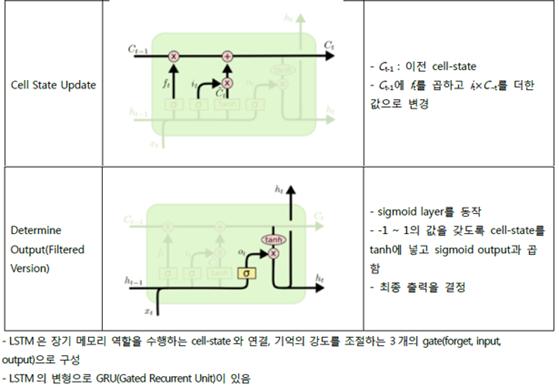

[정의] RNN에서 학습방법의 역전파 거리가 늘어날경우 gradient값이 폭증하거나 사라지는 문제점을 개선하는 알고리즘

[RNN의 장기의존성(Long-Term Dependency) 문제] 이전 정보입력 위치와 현재 입력위치가 멀 경우 학습데이터 유실되는 문제

※ tanh : Hyperbolic Tangent. 시그모이드 함수를 조금 변형하여 1 ~ -1까지 출력되는 함수. 시그모이드보다 기울기가 가파라서 학습속도가 빠르지만, 양끝단 포화가 더 심하여, Vanishing Gradient 문제에서는 취약함.

※ 시그모이드 3개는 단지 아날로그적 스위치 역할수향. 노드의 전달 함수는 하이퍼탄 이용.

'ITPE > 인공지능_데이터분석' 카테고리의 다른 글

| 강화학습(Reinforcement learning) 기본 내용 (2) | 2025.02.06 |

|---|---|

| Boxplot (0) | 2021.04.12 |

| 혼동 행렬(confusion matrix)을 이용한 분류 모형의 평가지표 (0) | 2021.04.09 |