[정의] 유럽의 개인에 대한 개인 정보 보호권 및 개인 정보의 자유로운 이동 보장을 위해 유럽연합 (EU)가 제정한 국제규정

[필요성] EU 권역내 개인정보의 자유로운 이동 보장, 일관성 있는 개인정보보호체제 확립

[주요골자]

① EU 역내 국민의 개인정보를 처리하는 역외 기업에게도 적용

② 중대 사항 위반 시 최대 전년도 글로벌 매출액의 4%까지 벌금이 부과

③ 개인정보처리 기준을 매우 향상

④ 정보주체인 개인의 권리를 확대하기 위해 데이터 삭제권과 이동권 등을 법제화

[GDPR 의 개인 정보처리 원칙] 적법성, 목적제한, 정보처리 최소화, 정확성, 기간제한, 기밀성/무결성, 책임성

[주요내용]

1) 적용대상 : 개인정보, 가명화정보, 민감정보

2) 적용범위 : 물리적범위(DB, 컴퓨터기반 파일링 시스템 등), 지리적 범위(EU역내/EU역외)

3) 적용대상주체 : EU 역내 거점을 둔 사업장(자회사, 지점, 판매소, 영업소 등), EU 역외 거점을 둔 사업장

4) 주요원칙 : 개인정보의 처리원칙(적법, 공정, 투명성, 목적제한, 개인정보처리 최소화), 동의(구체성 추가. 진술 적극적 행동 등), 아동 개인정보(만 16세 미만시 친권자 동의), 민감정보(법률적 이유 제외하고 원칙적으로 처리금지)

[DPO(Data Protection officer)] 개인정보보호책임자 지정

[컨트롤러] 개인정보의 처리 목적 및 수단을 단독 또는 공동(jointly)으로 결정하는 자연인, 법인, 공공기관, 에이전시 기타 단체 ≒ 개인정보 위탁자

[의무] 개인정보 처리의 성격, 범위, 목적, 위험성 등을 고려하여 GDPR 준수 하에 개인정보 처리가 수행되고 있다는 것을 보장. 컨트롤러는 개인정보에 관한 모든 1차적인 책임을 짐

[공동 컨트롤러] 둘 이상의 컨트롤러가 공동으로 개인정보 처리의 목적과 수단을 결정하는 경우.

[프로세서] 컨트롤러를 대신하여 개인정보를 처리하는 자연인, 법인, 공공기관, 에이전시, 기타 단체. 컨트롤러의 명령으로만 개인정보 처리 ≒ 개인정보 수탁자

[의무]

1)컨트롤러의 서면승인: 컨트롤러의 사전적/구체적 또는 일반 서면 승인 없이 다른 프로세서를 추가할 수 없음.

2) 프로세서의 사용: 개인정보의 처리가 GDPR 의 요구사항을 준수하고 정보주체의 권리의 보호를 보장하는 방식으로 적절한 기술적, 조직적 조치의 이행을 보증하는 프로세서만을 이용

3) 문서화 된 지시사항: 원칙적으로 문서화된 지시사항에 의해서만 처리

4) 기밀 준수, 보안조치, 컨트롤러 권리 보장, 개인정보 폐기, GDPR 준수 입증 등

5) 공동 프로세서: 만약 다른 프로세서가 개인정보 보호의무를 이행하지 않을 경우 프로세서는 다른 프로세서의 의무이행에 대해 컨트롤러에게 전적으로 책임.

[특징] 프로세서가 처리의 목적 및 수단을 결정함으로써 GDPR을 위반하는 경우, 해당 처리에 관해 컨트롤러로 간주.

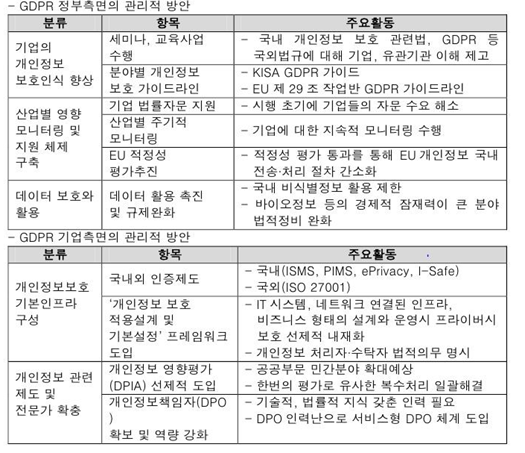

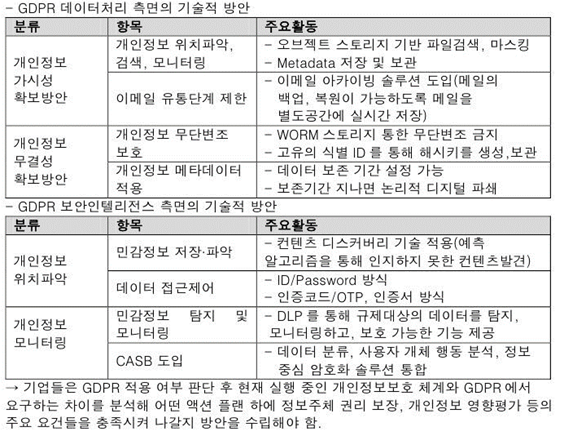

[EU GDPR의 기업 대응방안 및 EU GDPR 적정성 평가]

'ITPE > 보안' 카테고리의 다른 글

| 프라이버시 보존형 데이터 마이닝(PPDM) (0) | 2021.03.28 |

|---|---|

| 프라이버시 보호모델 (KLT 모델) (0) | 2021.03.27 |

| 개인정보영향평가(Privacy Impact Assessment) (0) | 2021.03.27 |

| SSO, EAM, IAM (0) | 2021.03.27 |

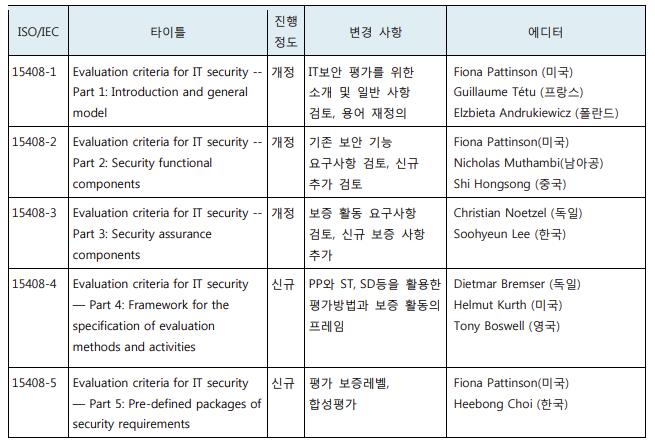

| CC(Common Criteria) (ISO/IEC 15408) -> 2020년 개정 (0) | 2021.03.27 |